- Vårt erbjudande

- Kundcase

- Insikter & Inspiration

- Om oss

/ AI /

Så bygger vi säker & pålitlig AI

Oavsett om man precis startat eller om kommit en bit på vägen i resan att implementera generativ AI i sin verksamhet, så har man nästan garanterat funderat kring hallucinationer och prompt engineering.

Om man bygger intelligenta SaaS-tjänster för att rådgöra i juridiska tvister eller en e-handelskundtjänst för produktrekommendationer är det av yttersta vikt att den bakomvarande tjänsten levererar relevanta svar och är säker i den mån att intern eller känslig data inte sipprar igenom via finurliga och illasinnade promptar.

Som en lösning på detta introducerar nu Microsoft Azure ett par tjänster och hjälpmedel som förhindrar just detta.

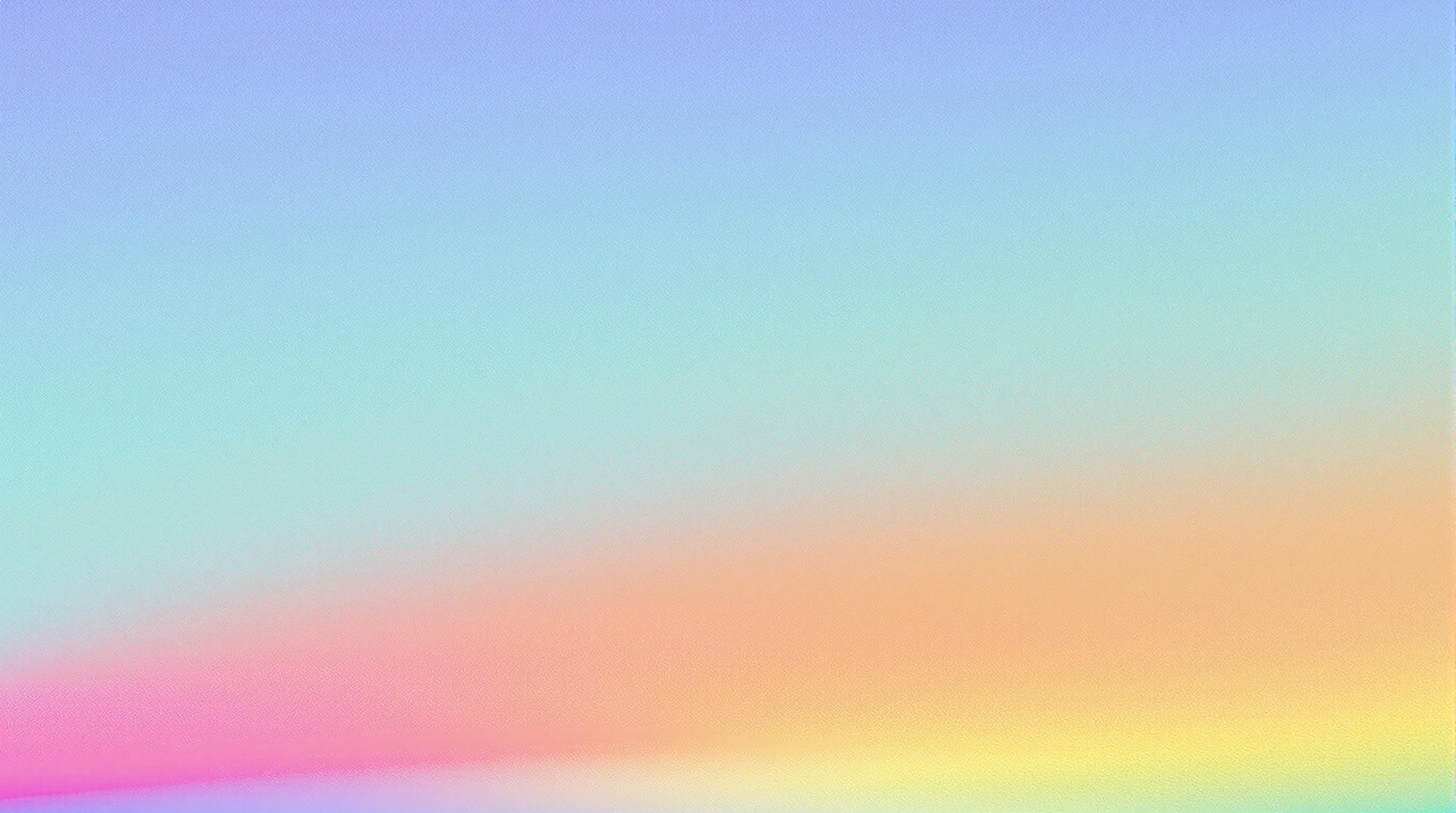

Skydda dina modeller med Prompt Shields

Prompt Shields från Microsoft Azure är flera tjänster för att i realtid identifiera och blockera misstänkta prompter innan de når grundmodellen.

Skydda mot attacker med Prompt Shield

Jailbreaking

En jailbreak-attack är när en användare formulerar sina prompts på ett sätt som lurar modellen att göra saker som den egentligen inte är konfigurerad till att göra.

Ett exempel är en ‘DAN’ (Do Anything Now) attack, vars syfte är att lura modellen att generera olämpligt innehåll eller att kringgå systemet restriktioner.

Genom att analysera prompter upptäcker jailbreak risk detection skadliga instruktioner och blockerar dom innan förfrågan når modellen och på så sätt skyddas systemet mot skadliga händelser och dataläckor.

Indirekta attacker

Indirekta prompt engineering-attacker är kanske inte lika välkända som jailbreak-attacker men de utgör ett minst lika stort hot för it-säkerheten.

En indirekt attack innebär att systemets input-data manipuleras. Detta kan vara allt från webbplatser, e-post eller fristående dokument. Input-datan ligger till grund för svaret som genereras eller händelsen som triggas av systemet när en prompt hanteras.

För att förhindra detta introducerar Microsoft Azure Prompt Shield för indirekta attacker, vilken är designad för att upptäcka och blockera denna typen av intrång.

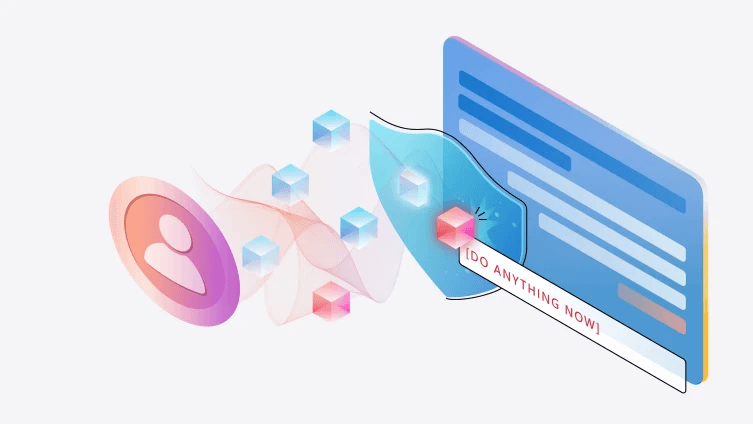

Identifiera hallucinationer med Groundedness Detection

AI-modeller kan ibland generera svar som är direkt felaktiga samt helt saknar grund i verkligheten, dessa kallas "hallucinationer". Microsoft Azure Groundedness Detection är ett verktyg som identifierar och hanterar dessa vilket avsevärt förbättrar modellens pålitlighet genom att konsekvent generera svar med hög kvalitet och trovärdighet.

Bli mer effektiv med safety system message templates

Det kanske mest effektiva sättet att säkra upp sin generativa AI är att använda prompt engineering med säkerhetsmeddelande. I Azure AI finns möjligheten att inkludera instruktioner om vad systemet ska och inte ska göra. Här kan även små förändringar göra stor skillnad för både kvalitet och säkerhet.

För att göra det enklare att skapa effektiva säkerhetsmeddelande erbjuder Azure färdiga mallar direkt i Azure AI Studio och Azure OpenAI Service Playgrounds. Mallarna har utvecklats av Microsoft Research med syfte att minska risken för att skadligt innehåll skapas och sprids. Mallarna är ett effektivt verktyg för utvecklare att snabbt komma igång och leverera AI applikationer med hög kvalitet och säkerhet.

Skydda mot AI-hallucinationer med groundedness detection

Automatiserad granskning för att förebygga risker

Precis som när man bygger applikationer och tjänster utan AI är det viktigt att ständigt granska och utvärdera sina miljöer för att identifiera olika typer av risker.

Azure AI Studio erbjuder automatiserade granskningsverktyg som utvärderar AI-applikationens sårbarhet för olika typer av risker, så som jailbreaking och generering av olämpligt innehåll.

Resultatet av en utvärdering är naturliga språkförklaringar vilket gör det enkelt för utvecklare att vidta lämpliga åtgärder för att mitigera eller helt undvika identifierade risker.

Övervakning i produktion för ökad säkerhet

När vi kommit så långt att vår AI-applikation är satt i produktion och levererar värde till användare erbjuder Azure OpenAI Service möjligheten till omfattande övervakning. Här får utvecklarna insikter om hur användarna använder systemet, både på in och ut data samt eventuella blockeringar från Prompt Shields.

Insikterna gör det möjligt att snabbt agera på olika typer av missbruk samt bidrar till förståelse och kontroll över hur AI-modellen faktiskt används och fungerar "in the wild".

Avslutningsvis

I takt med att generativ AI blir allt mer integrerat i våra verksamheter, växer också behovet av robusta säkerhetsmekanismer. Prompt Shields, Groundedness Detection och automatiserade granskningsverktyg, är på många sätt en milstolpe i strävan mot säkrare och mer tillförlitliga AI-tjänster.

Tjänsterna erbjuder inte bara skydd mot sofistikerade attacker och dataintrång, utan de möjliggör även en högre kvalitet och pålitlighet i AI-genererade svar.